Falamos bastante aqui no Saúde Digital de como a tecnologia vai transformar a medicina. No entanto, vamos seguir o caminho oposto. Você sabia que os conhecimentos biológicos também estão transformando a ciência da computação. Já ouviu falar sobre engenharia neuromórfica?

É a busca por materiais, equipamentos e processos que funcionam de forma semelhante ao sistema nervoso humano. Os dispositivos neuromórficos estão sendo desenvolvidos para enfrentar limitações que estão no limiar do futuro da computação: a eficiência energética dos equipamentos e a otimização da capacidade de processamento.

Como é feita a computação tradicional? O que muda com a computação neuromórfica?

A computação se baseia em associar o comportamento de um material sólido (como um semicondutor) com uma informação útil. Por exemplo, pode-se usar como parâmetro campo magnético produzido quando uma corrente passa por um componente do computador, por exemplo. Com isso, conseguem armazenar o sinal elétrico de forma digital, que se baseia na presença ou ausência de um estado.

Portanto, o digital é a utilização de uma característica física (ausência ou presença de campo eletromagnético) em um componente do computador para gerar, armazenar ou transmitir dados.

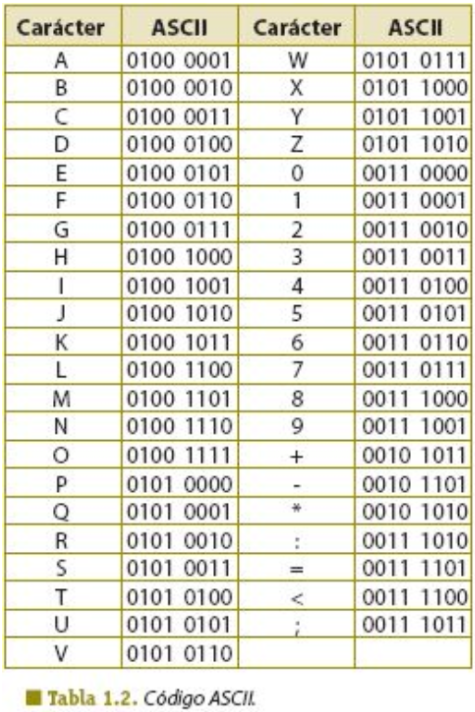

Uma sequência desses estados pode ser interpretada como uma informação. Atualmente, utilizamos a linguagem bit, que transforma a presença de um estado no algarismo 1 e a ausência em 0. Veja como isso é traduzido em letras do alfabeto na linguagem de bits atual:

Os materiais sólidos podem ser classificados de 3 diferentes formas:

- amorfos — os átomos e moléculas estão dispostos de forma completamente aleatória;

- uni-cristalinos — apresentam um único padrão de repetição estrutural;

- policristalinos — é possível identificar padrões regulares em determinadas regiões do sólido. Mas como um todo, o material contém diversos padrões distintos, mas dispostos de maneira aleatória.

Em dispositivos tradicionais de computação, geralmente são utilizados os semicondutores com estrutura monocristalina.

No entanto, as outras configurações de sólidos podem ser empregadas em diversas funcionalidades ou em novos modelos computacionais.

Estrutura cristalina e semicondutores

Os semicondutores são materiais que se comportam como isolantes em níveis menos energéticos. Mas que, em algumas condições, tornam-se condutores. Com isso, conseguem armazenar o sinal elétrico de forma digital, isto é, presença ou ausência de um estado.

Como vimos, isso pode ser interpretado como um bit (1 ou 0). Cada bit é armazenado como uma alteração na estrutura cristalina de um semicondutor. Uma sequência de 8 bits (1byte) pode ser codificada para representar alguma informação importante, como a de um número, uma letra ou determinada uma cor. Os bytes são combinados em códigos mais complexos que dão funcionalidade aos softwares e sistemas.

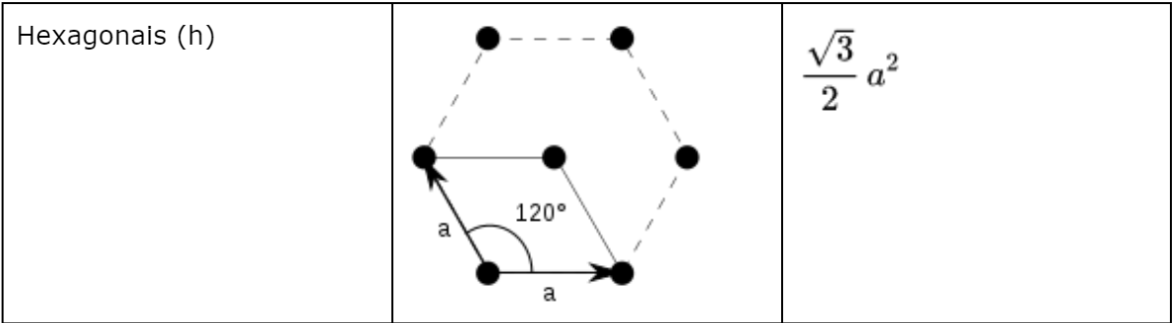

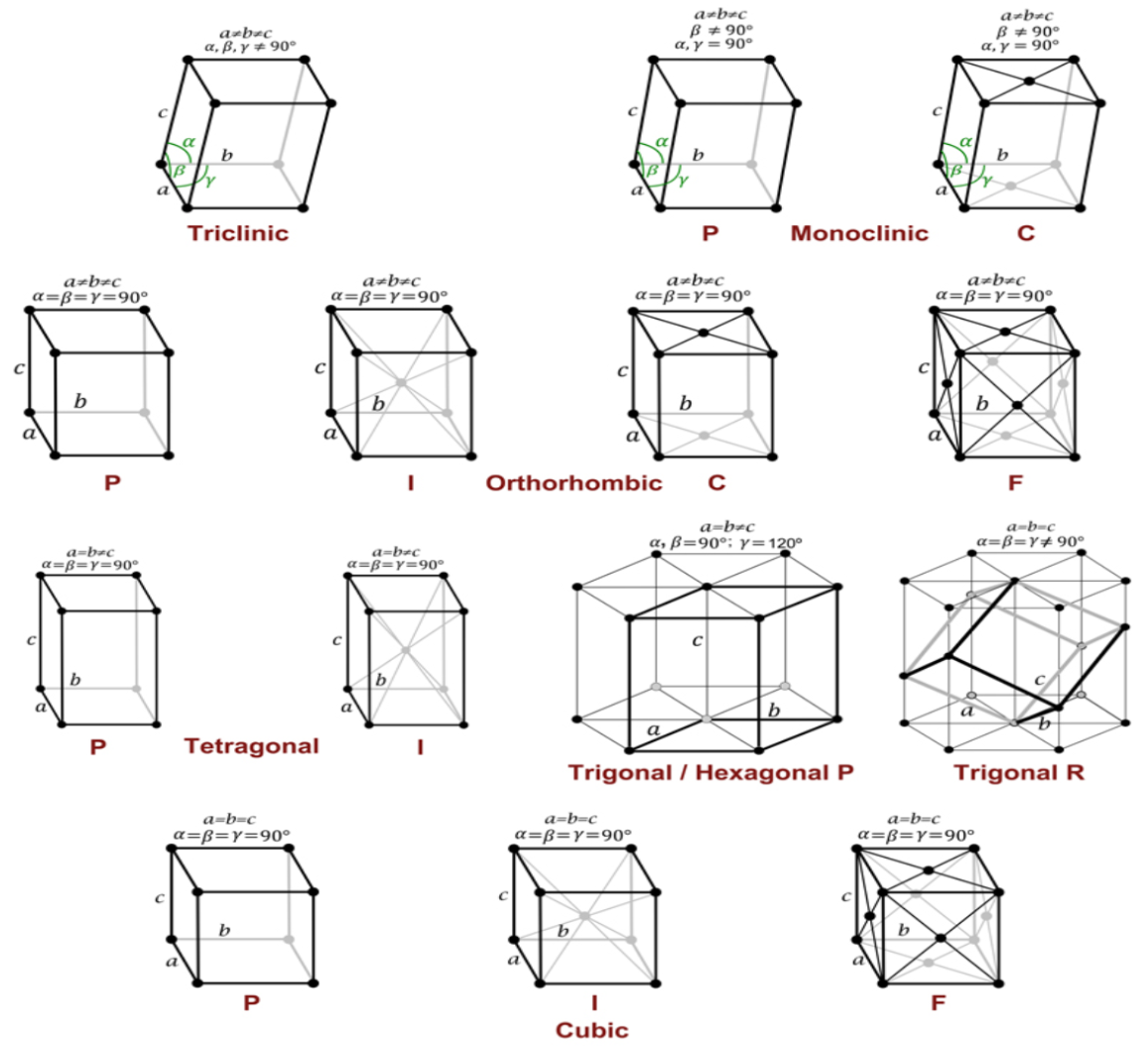

A estrutura cristalina pode ser representada esquematicamente em modelos conhecidos como “Rede de Bravais”. Existem 5 tipos de redes de Bravais 2D:

Os sólidos cristalinos geralmente se enquadram em uma das 14 representações a seguir:

A menor região de uma rede cristalina (que é delimitada por dois pontos “vizinhos”) é chamada de “célula unitária”. É nessa célula unitária que a unidade mais básica de uma informação é armazenada. O desenvolvimento de microchips envolve o mapeamento do comportamento da estrutura cristalina dos semicondutores e a sua modulação por meio de peças chamadas transistores .

Isso é muito diferente da arquitetura do nosso cérebro, que desenvolve a informação em uma unidade muito maior, o neurônio. Além disso, o sinal não apresenta essa característica dual (1 ou 0), mas analógica (com múltiplos valores contínuos) Então, a mudança para um paradigma de computação neuromórfico exige uma adaptação muito grande da engenharia e da ciência da computação.

No entanto, de certa forma, o futuro da computação depende disso e de outros esforços devido à Lei de Moore e de outras limitações das tecnologias baseadas em transistores tradicionais.

Lei de Moore e microchips: por que a computação neuromórfica pode ser necessária?

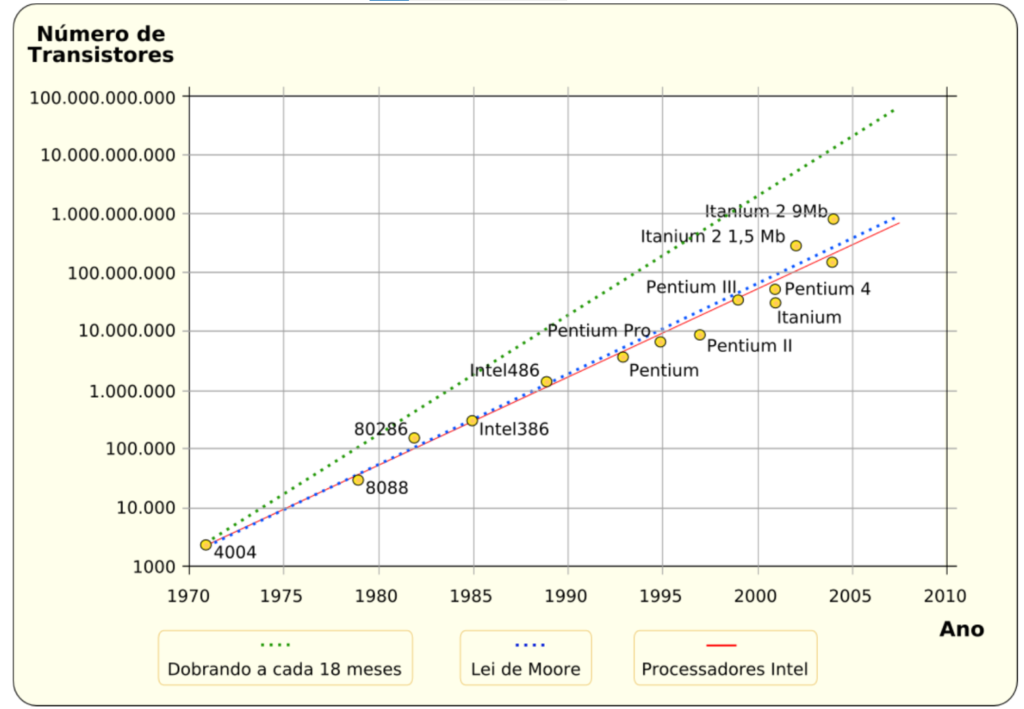

A capacidade computacional de um microchip é determinada pelo número de transistores que ele contém. São eles os responsáveis pelo sinal digital em um computador. Após uma observação do desenvolvimento computacional, o químico Gordon Moore fez uma previsão sobre o futuro da computação. Então, surgiu a lei que leva o seu nome, a qual estima que a tecnologia evoluiu de uma forma que:

“o número de transistores dos chips teria um aumento de 100%, pelo mesmo custo, a cada dois anos”

Para aumentar o número de transistores em uma mesma área de microchip, era necessário reduzir o tamanho dos transistores. Com isso, previa-se o fim da Lei de Moore quando uma das seguintes hipóteses se realizasse: (1) o custo de produção escalaria mais do que a capacidade de aumentar o número de transistores, (2) o tamanho dos transistores se tornaria próxima ao de um átomo, atingindo um limite físico, (3) os custos energéticos e o aquecimento gerado por uma maior densidade de transistores em um microchip tornariam seu uso inviável no dia a dia.

Por volta da década de 2010

O tamanho dos transistores se aproximava de 10 nanômetros. Então, muitas empresas estimaram que a Lei de Moore chegaria ao fim em breve. Afinal, os custos de pesquisa e desenvolvimento de microchips menores seriam muito elevados. Portanto, não teriam um bom custo-benefício para uso comercial.

No entanto, em 2014, a IBM anunciou que tinha desenvolvido um microchip de 7 nanômetros com preços comerciais. Com isso, as previsões do fim da Lei de Moore foram adiadas.

Desde então, a tecnologia evoluiu tanto que novos limites inferiores foram atingidos. Por exemplo, hoje em dia, os iPhones mais novos têm um microchip com transistores de 5 nanômetros. O próximo processador desses aparelhos, o A16, contará com transistores de 4 nanômetros.

A previsão é que:

- chips de 3 nanômetros sejam lançados até 2023;

- e os de 2 nanômetros, até 2024/2025.

Então, a Lei de Moore possivelmente chegará ao fim real em relação ao tamanho dos transistores. Afinal, eles terão se tornado tão pequenos quanto a menor distância possível entre dois átomos em temperatura ambiente.

Com isso, chega ao limite a capacidade de otimização de computadores por meio do aumento da densidade de transistores em um microchip. A computação precisará evoluir para outros caminhos, como:

- o desenvolvimento de novos paradigmas de computação, como a computação quântica e a computação neuromórfica;

- a otimização de outros componentes dos computadores, como a memória RAM;

- criação de algoritmos mais eficientes e que demandam menor poder computacional.

Em 2017, o CEO da Intel deu uma entrevista dizendo que a companhia estava investindo na computação quântica e na neuromórfica como estratégias para o mercado pós-Lei de Moore.

Hoje, vamos falar da computação neuromórfica, que se baseia no comportamento fisiológico dos neurônios e nas redes neurais do cérebro. Nas próximas semanas, discutiremos a computação quântica e seu papel na medicina do futuro.

A computação neuromórfica

A computação neuromórfica pode se desenvolver das seguintes formas:

- uso de algoritmos que se baseiam em modelos de sistemas neuronais;

- componentes computacionais que se comportam de forma semelhante a uma rede de neurônios.

Quais são as características dos sistemas neurológicos que ela busca adaptar?

Veja as principais:

- processamento paralelo massivo. Em outras palavras, a realização de centenas de tarefas computacionais integradas simultaneamente. Os computadores conseguem realizar milhares de tarefas a cada instante isoladas. No entanto, quando o nível de integração de dados entra aumenta, os computadores enfrentam limitações significativas;

- plasticidade, que é a capacidade de se alterar e se adaptar para otimizar a capacidade de processamento e de aprendizado;

- responsividade a eventos, que a capacidade de controlar a própria função de acordo com estímulos do meio ambiente ou internos. Na computação atual, praticamente todos os componentes do computador precisam estar altamente ativos para ele operar. Nos sistemas biológicos, determinadas regiões do cérebro podem ficar em um estado latente até serem recrutadas mais ativamente;

- habilidade de generalização, o qual envolve aplicar um aprendizado contextual em contextos relativamente diferentes do original;

- tolerância a falhas, os softwares e hardwares podem ter seu funcionamento comprometido mesmo com falhas pequenas. Nos sistemas biológicos, há a capacidade de readaptação mesmo quando uma parte significativa do tecido neuronal foi comprometida.

Além disso, outra característica da computação neuronal é a sua alta eficiência energética. O cérebro consegue executar tarefas extremamente complexas para um computador sob um custo energético muito menor.

À medida que a inteligência artificial vem se desenvolvendo e surgem softwares mais complexos/integrados, o custo energético escala absurdamente. Estima-se que, hoje em dia, até 3,5% do consumo energético mundial esteja sendo direcionado para a IA.

Emulação de redes neurais em hardwares

Vamos, primeiro, relembrar o comportamento mais básico de uma rede neural

- Neurônio pré-sináptico — produz o sinal que pode resultar em uma sinapse;

- Sinapse — ela pode ser química (neurotransmissores) ou elétrica (fluxo de íons através de canais de membrana);

- Neurônio pós-sináptico — recebe o estímulo sináptico e deflagra eventos internos

Se a intensidade do sinal foi suficiente para ultrapassar o potencial de ação, ocorre a transmissão do sinal. Caso seja insuficiente, o neurônio pós-sináptico não transmite o sinal. Contudo, de certa forma, ele pode armazenar parte daquela informação.

Então, apesar de não transmitir o sinal elétrico, ele pode ficar em um estágio intermediário de polarização. Assim, caso um futuro sinal mais fraco seja recebido, o potencial de ação é deflagrado. Há também sinapses inibitórias, que hiperpolarizam os neurônios e dificultam a passagem do sinal. Essa “memória” é um dos fatores buscados pela computação neuromórfica.

Nos memristores, há um componente que atua como neurônio pré-sináptico, emitindo pulsos elétricos. Outra peça atua como sinapse, modulando a intensidade do sinal. Por fim, temos o componente que atua como neurônio pré-sináptico, determinando, em última instância, o armazenamento da informação.

Sobre Hoje

Atualmente, o processamento de um computador é feito no CPU. Já a informação é guardada na memória de armazenamento. A transmissão de dados entre o CPU e a memória de armazenamento é intermediada pela memória volátil (de trabalho), a qual guarda as informações por um período breve de tempo para que elas possam ser utilizadas pelo computador.

Essa comunicação é feita por meio de correntes elétricas através dos barramentos (“fios”) dos computadores. Nesse processo, há perda de sinal elétrico na forma de calor, o que provoca uma redução da eficiência energética. Com os memristores e a computação neuromórfica, acredita-se que o processamento e o armazenamento poderão ocorrer na mesma unidade.

Autores:

Ricardo Tadeu de Carvalho, médico, especializado em produção de conteúdo para a área da saúde. Colunista no Saúde Digital Ecossistema. CEO do RT Marketing Médico.

Lorenzo Tomé, médico, host do podcast Saúde Digital. CEO do Saúde Digital Ecossistema.

Excelente revisão sobre o futuro da computaçao.

Obrigada pelo seu comentário!